Texet d’opinions dans Le Devoir

Montréal, leader de l’IA responsable ou vernis moral d’une nouvelle démesure?

iStock, montage Le Devoir

Si Montréal est devenue le leader mondial de l’IA responsable, cet écosystème constitue dès lors la conscience morale du capitalisme algorithmique, rapportent les auteurs.

Jonathan Durand Folco et Jonathan Martineau

Les signataires sont les auteurs du livre « Le capital algorithmique. Accumulation, pouvoir et résistance à l’ère de l’intelligence artificielle » (Écosociété, 2023).

30 septembre 2023

Idées

Ce n’est un secret pour personne, Montréal est devenue un pôle dynamique de calibre international dans le champ de l’intelligence artificielle (IA). Le sommet international All In, qui a eu lieu les 27 et 28 septembre derniers, célèbre d’ailleurs la spécificité de cette ville qui serait « le hub de l’IA en Amérique du Nord ».

La présence de l’Institut québécois d’intelligence artificielle (Mila), fondé par le parrain de l’apprentissage profond Yoshua Bengio, la supergrappe Scale AI, financée à hauteur de 337 millions par les gouvernements canadien et québécois et coprésidée par Hélène Desmarais, ainsi que les relations très étroites entre les universités, l’État et les grosses pointures de l’industrie constituent un « écosystème tricoté serré ». Ils font ainsi de Montréal l’un des foyers d’innovation, de recherche et de développement de machines algorithmiques à l’avant-scène de ce que Klaus Schwab, président du Forum économique mondial, appelle la « quatrième révolution industrielle ».

Plus précisément, Montréal occupe une niche unique, celle de « leader mondial de l’IA responsable ». La Déclaration de Montréal pour un développement responsable de l’IA (lancée en 2017), le fort réseau de chercheurs sur les effets sociaux de l’IA et le leadership de Bengio en matière d’appels à la réglementation de l’industrie et à une meilleure gouvernance de ces outils sont différents éléments qui militent en faveur de ce titre honorifique.

Limites de l’IA responsable

Et pourtant, l’approche éthique en matière de développement responsable de l’IA montre plusieurs limites. Premièrement, les déclarations éthiques qui se comptent par centaines à travers le monde, et dont les GAFAM sont souvent signataires, n’ont pas changé grand-chose jusqu’ici à la trajectoire globale de l’IA qui amplifie les inégalités sociales, effrite la vie démocratique et participe à l’aggravation de la crise climatique.

Deuxièmement, l’approche volontaire en matière d’IA responsable, comme le code de conduite volontaire annoncé par le ministre de l’Innovation, des Sciences et de l’Industrie, François-Philippe Champagne, de même que les futures lois canadiennes (C-27) sont taillées sur mesure pour l’industrie afin de rassurer les investisseurs et de recréer la confiance du grand public dans les technologies algorithmiques. Cette approche s’inscrit dans la lignée de la responsabilité sociétale des entreprises, qui sert davantage à leur donner bonne image et à créer de nouveaux marchés qu’à résoudre effectivement le problème des inégalités et la crise écologique.

Troisièmement, l’éthique se limite bien souvent à la réduction de biais algorithmiques et aux questions de transparence, qui passent sous silence le rôle pourtant central de la logique capitaliste. L’éthique joue donc le rôle de « conseiller du prince », et vise ainsi à réduire les méfaits de l’IA et à lui donner une légitimité (acceptabilité sociale) plutôt que de remettre en question son emprise sur les États, le développement territorial, nos relations sociales et nos subjectivités.

Un nouveau stade du capitalisme

Depuis la crise financière mondiale de 2007-2008, le capitalisme néolibéral, financiarisé et mondialisé a été frappé par une importante crise de légitimité, laquelle s’est accompagnée du développement parallèle de l’infrastructure nuagique, des données massives, de l’apprentissage automatique, des médias sociaux et des téléphones intelligents ainsi que de la consolidation des grandes plateformes numériques. Cela a contribué au passage vers un nouveau stade du capitalisme, dans lequel l’extraction et la valorisation de données personnelles représentent un axe central d’accumulation capitaliste.

Les données deviennent le « nouveau pétrole » et l’IA la « nouvelle électricité » qui permettent de faire fonctionner nos appareils intelligents et d’automatiser une foule de processus dans les sphères de l’entreprise, des chaînes d’approvisionnement, de la fonction publique, des transactions financières, etc. Autrement dit, le « capital algorithmique », c’est-à-dire la dynamique d’accumulation capitaliste appuyée sur l’IA, devient un acteur central de la vie économique et des relations sociales en général. Nous gardant rivés à nos écrans par des techniques de design addictif, nous sollicitant en permanence, dictant nos comportements par diverses recommandations, il remplace même parfois le jugement humain par le biais de systèmes décisionnels automatisés.

L’industrie de l’IA d’ici et d’ailleurs participe de plain-pied à la production du capital algorithmique, qui façonne aujourd’hui une bonne partie de nos vies, souvent à notre insu. Trop souvent, l’approche de l’IA responsable passe sous silence, voire cautionne implicitement, ce système socio-économique. Certes, on met en évidence certaines dérives de l’IA, à la pièce, sans toutefois reconnaître le rôle majeur que le capitalisme et les géants technologiques jouent dans la création, la sélection et le déploiement de ces machines.

De fausses solutions

L’IA responsable se donne souvent le beau rôle dans la résolution de graves problèmes de notre époque, comme la crise climatique. Or, sa prétention de vouloir accélérer la transition écologique par les algorithmes, les centres de données « verts » et les objets connectés omet le coût énergétique énorme de cette infrastructure industrielle planétaire, qui inclut l’extraction de métaux rares au Congo, les giga-usines en Chine, les entrepôts inhumains d’Amazon, la consommation massive d’eau pour refroidir les infrastructures qui entraînent ChatGPT et la montagne de déchets électroniques qui s’accumulent dans les pays du Sud.

Si Montréal est devenue le leader mondial de l’IA responsable, cet écosystème constitue dès lors la conscience morale du capitalisme algorithmique. Malheureusement, celle-ci participe trop souvent à se donner bonne conscience et à accompagner gentiment les acteurs privés, plutôt qu’à mettre en doute les mécanismes au coeur de ce système économique inégalitaire, antidémocratique et insoutenable.

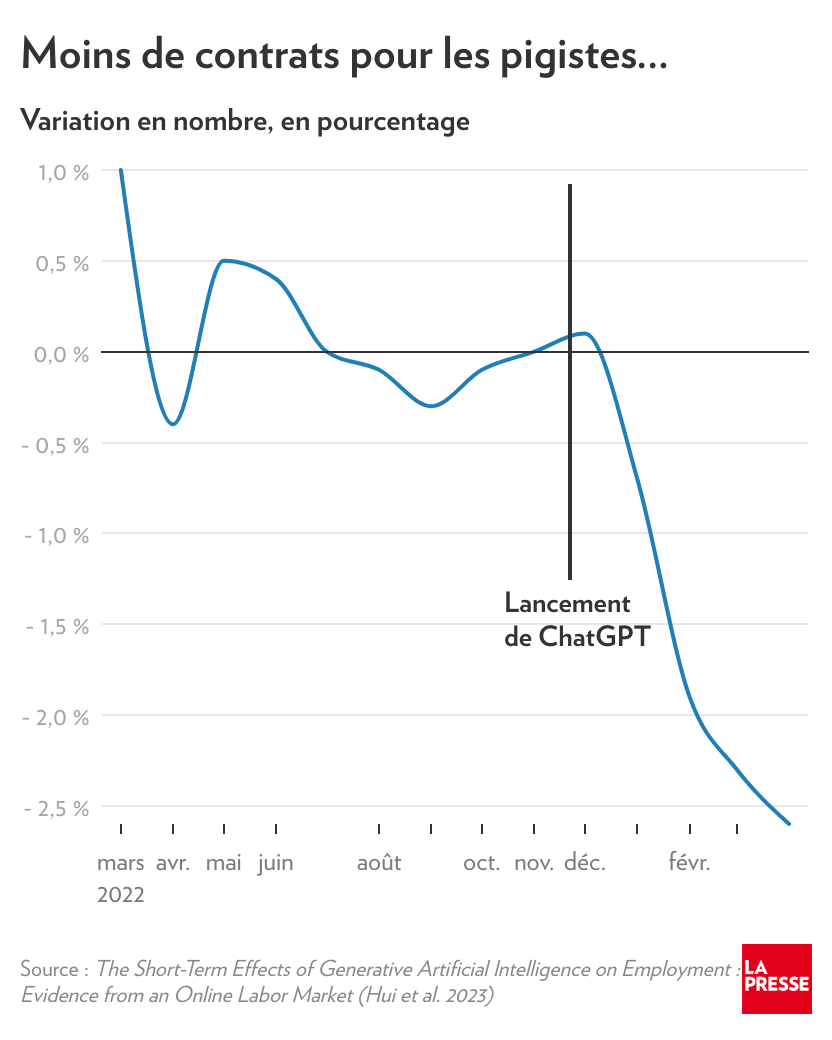

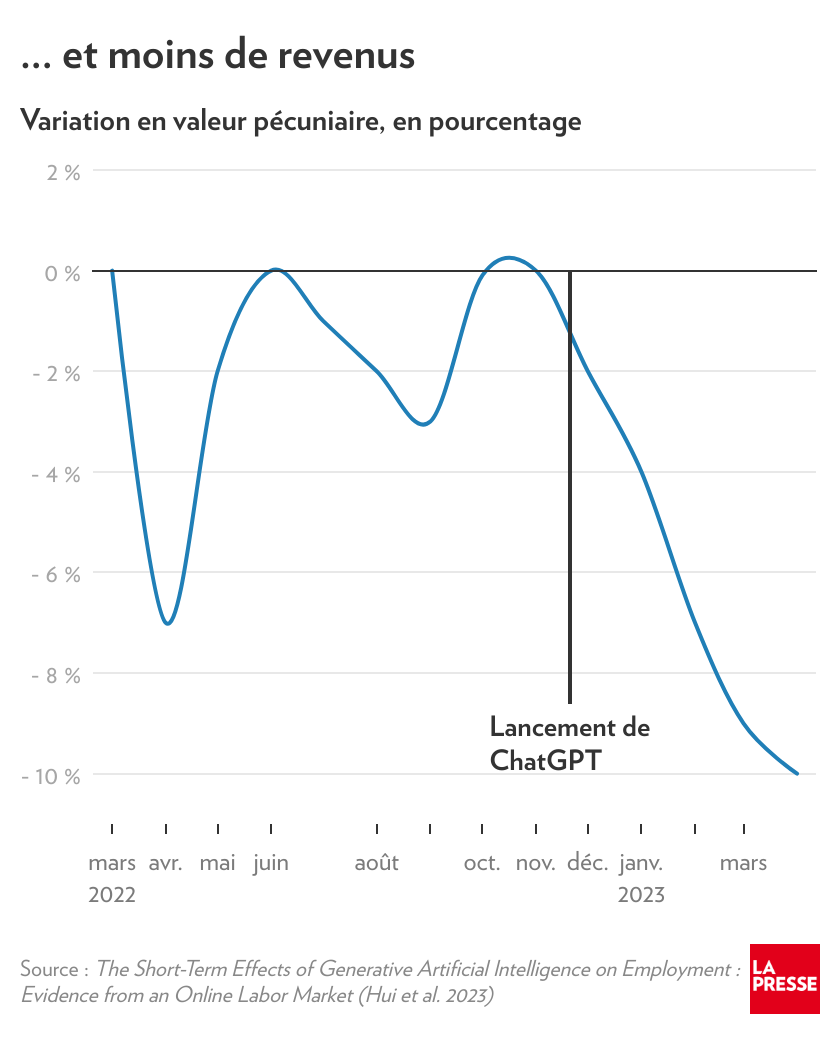

Le nom du sommet sur l’IA All In est d’ailleurs révélateur : comme au poker, on mise tout sur l’IA. Tout le reste, les effets néfastes, les injustices automatisées, la précarisation du travail, l’accélération de la crise écologique, la dégradation du débat public causée par les chambres d’écho et les filtres algorithmiques, ce n’est pas très important. Montréal n’arrête pas ce progrès, elle y participe de façon enthousiaste en lui donnant un vernis moral.