Montréal Des chercheurs travailleront à réduire la consommation d’énergie de la 5G

PHOTO LIONEL BONAVENTURE, ARCHIVES AGENCE FRANCE-PRESSE

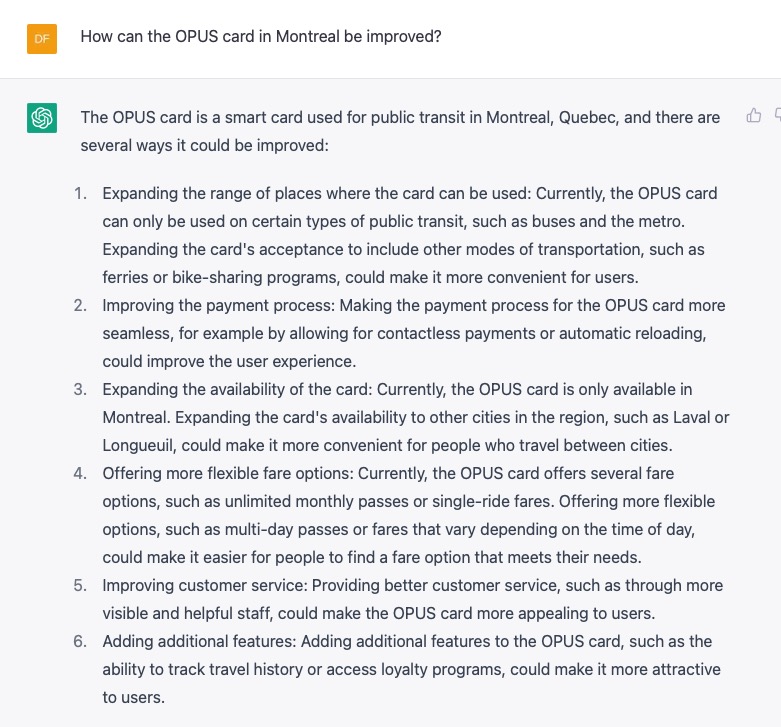

Le géant des télécommunications Ericsson s’allie avec trois établissements d’enseignement supérieur de Montréal et Environnement et Changement climatique Canada afin de réduire la consommation énergétique des réseaux 5G et leur impact environnemental, en recourant à l’intelligence artificielle.

Publié à 6h28

![]()

Frédéric Lacroix-Couture La Presse Canadienne

Sept professeurs et une vingtaine de chercheurs de Polytechnique Montréal, de l’École de technologie supérieure (ÉTS) et de l’Université Concordia prendront part à un programme de recherche au cours des trois prochaines années. Celui-ci sera appuyé par l’accélérateur mondial d’intelligence artificielle (GAIA) d’Ericsson, établi à Montréal.

L’objectif sera d’analyser de « bout à bout » le réseau 5G, des antennes jusqu’aux interactions avec les applications sur les téléphones et l’internet mobile, pour voir où des gains d’économie d’énergie sont possibles grâce à des algorithmes, explique le chef du site d’Ericsson à Montréal, Paul Baptista.

« La plupart du temps, l’équipement est à pleine capacité et roule, par exemple, à 100 % de ses performances. Mais peut-être qu’il y a des moments dans le réseau où on n’a pas besoin d’avoir toutes les lumières allumées », illustre M. Baptista en entrevue avec La Presse Canadienne.

Avec l’intelligence artificielle, les chercheurs tenteront de mettre au point des moyens qui permettront de réduire la quantité d’énergie dont ont besoin les stations de base pour transmettre des signaux aux appareils sans fil, mais sans affecter leur efficacité.

Un « catalyste », mais aussi polluant

Si une installation 5G consomme entre 8 et 15 % moins d’énergie qu’une installation 4G similaire, selon l’Association canadienne des télécommunications sans fil, il n’en reste pas moins que l’empreinte carbone de cette nouvelle génération pourrait s’avérer plus importante en raison des nouveaux usages.

La révolution numérique qui est promise avec la 5G pourrait entraîner « la fabrication des milliards de nouveaux objets connectés vendus pour profiter des nouvelles fonctionnalités disponibles », fait notamment état l’équipe du projet Chemins de transition, affiliée à l’Université de Montréal, dans son rapport sur le défi numérique.

Ces nouveaux appareils causeront une hausse de la consommation énergétique et nécessiteront l’extraction de ressources naturelles non renouvelables pour leur production, en plus de la construction de plusieurs infrastructures comme des antennes.

« On estime que le numérique devrait consommer trois fois plus d’énergie en 2025 qu’en 2010 », peut-on lire dans le rapport de l’organisation Chemins de transition.

Le 5G est un « catalyste pour l’économie verte », mais il est aussi polluant, reconnaît le professeur à l’ÉTS au département de génie des systèmes Mohamed Cheriet, qui prendra part au projet de recherche.

Il évoque que le secteur des technologies de l’information et de la communication (TIC) représente environ 5 % de la consommation mondiale d’énergie.

« La demande actuelle est de l’ordre de 1000 térawatts-heures annuellement. En 2008, on était à 2 %, et de 4 % en 2018. Il va falloir ramener (l’empreinte écologique) le plus bas possible. Si on reste au niveau de 1 ou 2 %, on est champion », soutient M. Cheriet.

Le secteur des TIC « est aussi polluant que l’aviation » en termes d’émissions de gaz à effet de serre (GES), indique le titulaire de la Chaire de recherche du Canada sur la durabilité écologique d’Eco-Cloud.

Il a bon espoir que les solutions qui découleront du programme de recherche avec Ericsson permettront d’améliorer l’efficacité énergétique de la 5G. Mais il y a aussi, selon lui, un travail d’éducation à mener auprès de la population pour en faire des utilisateurs du numérique « responsables ».

Actuellement, il n’existe aucune donnée au Canada sur l’impact actuel ou à venir du déploiement de la 5G et des TIC sur l’empreinte carbone ou les émissions des GES au pays. L’implication d’Environnement et Changement climatique Canada dans ce projet de recherche devrait venir combler cette absence d’informations.

Le choix d’Ericsson de mener ce projet dit novateur dans la métropole québécoise s’explique notamment par une collaboration de longue date entre l’entreprise suédoise et les institutions académiques montréalaises, ainsi que par l’expertise reconnue de Montréal en matière d’intelligence artificielle.

L’initiative est également soutenue financièrement par le gouvernement du Québec par l’entremise de son programme InnovÉÉ-innovation en énergie électrique.

Cette dépêche a été rédigée avec l’aide financière des Bourses de Meta et de La Presse Canadienne pour les nouvelles.

https://www.lapresse.ca/affaires/techno/2022-10-14/montreal/des-chercheurs-travailleront-a-reduire-la-consommation-d-energie-de-la-5g.php